Uma coisa que tem que ficar claro: Os gestos das letras do alfabeto (datilologia libras) não é falar Libras.

Libras não é uma versão gesticulada do português. Muitos deficientes auditivos sabem falar libras, mas não sabem escrever em português, portanto, não saberiam soletrar uma palavra.

Se seu objetivo for surdos-mudos, de nada adianta fazer o alfabeto. Eles talvez só vão saber gesticular o próprio nome.

Para identificar a Libras mesmo, você precisa:

a) Capturar a posição relativa da mão (faz diferença se um gesto é feito na altura da cabeça ou na altura do peito, por exemplo);

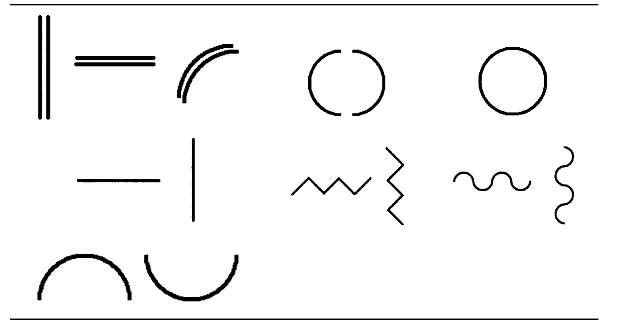

b) O movimento realizado pela mão. Uma boa descrição desses movimentos (em anexo) pode ser encontrada em:

Carneiro, Alex T. S., Cortez, Paulo C. e Costa, Rodrigo C.S. , “Reconhecimento de Gestos da LIBRAS com Classificadores Neurais a partir dos Momentos Invariantes de Hu,” in Interaction 09 - South America, São Paulo, 2009.

c) A configuração dos dedos. Uma lista completa das 61 posições possíveis em Libras pode ser encontrada em (em anexo):

Pimenta, Nelson e Quadros, Ronice Müller , Curso LIBRAS 1, 4th ed.: Vozes, 2010.

Os movimentos são bastante amplos. Tem movimentos que começam nas pernas e vão até a cabeça, por exemplo. Isso descarta totalmente o uso do LEAP.

Não faz diferença se o sinal é gesticulado com a mão direita ou esquerda: a pessoa gesticula geralmente com base em sua mão primária. Esse detalhe deve ser levado em conta, pois você terá que tratar pessoas canhotas que gesticulam de maneira “refletida”.

Por fim, você também pode levar em consideração a identificação de uma só palavra gesticulada, ou de um diálogo. O segundo é mais complexo que o primeiro, não só pelo fato dos sinais terem que ser separados um dos outros, mas pelo fato de entre um sinal e outro haver um gesto que deve ser descartado (chamado de epêntese). Por exemplo, se alguém gesticula a balavra boi (que basicamente é fazer um chifre com os dedos indicadores na cabeça) e na sequencia vai gesticular a palavra polvo (cujo gesto começa ao lado da perna), haverá o deslocamento da mão da cabeça até a perna. E esse deslocamento não representa gesto nenhum.

No seu caso, como se trata de um TCC de graduação, acho que tratar a datilologia é suficiente. Já vai ser um ótimo tema. É mais simples, mas não chega a ser trivial. Também tem cunho social - pois pode aproximar pessoas que falam no universo Libras e pode criar um dispositivo de entrada gestual para quem é surdo e mudo. E também já vai te colocar em contato com várias das tecnologias que você usaria num futuro mestrado, em especial, os classificadores. Os sinais também são gesticulados de maneira relativamente controlada, o que facilita enormemente a separação da mão do resto da cena (segmentação).

Não recomendo Libras como um todo, pois além da classificação, você terá que se preocupar muito com rastreamento e segmentação. Na Libras mesmo, é muito mais difícil segmentar sinais que ocorrem ao lado da bochecha, por exemplo (já envolve detectores de pele, análise de contorno, etc). Deixe para ver isso no mestrado, pois você provavelmente terá disciplinas exclusivamente para tratar desse assunto, e um orientador especialista em reconhecimento de padrões para te dar as dicas.

Já com o trabalho em datilologia, você já entra no mestrado pronto para fazer as perguntas certas nas aulas de processamento de imagens e morfologia matemática. O que já é bem à frente do que eu mesmo entrei.